Das PDF dient ausschließlich dem persönlichen Gebrauch! - Weitergehende Rechte bitte anfragen unter: nutzungsrechte@asu-arbeitsmedizin.com.

Die Rolle der KI-Verordnung

New Psychological Stress Due to Artificial Intelligence? The Role of the AI Regulation

Recently, the hopeful view has spread that the forthcoming European AI regulation will not only provide an ethical response to the use of artificial intelligence (AI), but will also provide a decisive impetus for occupational health and safety with regard to mental stress. In contrast to this, the following section examines the thesis that, due to the restrictive nature of the legal framework of an internal market regulation, only a few aspects of occupational health and safety can be affected or formulated in requirements and that the dimension referred to as “ethical” satisfies a concept of ethics that is at best functional. The existing regulatory deficits and subjectivist attributions of responsibility for mental stress towards employees' resources smoulder almost as if under a burning glass. A brief outline of the problem is intended to illustrate the discomfort of this connection and the need to raise awareness. Michael Bretschneider-Hagemes

Ethische KI-Verordnung?

Lange vor dem Entwurf der KI-Verordnung im April 2021 gründete die EU-Kommission im Juni 2018 die „Hochrangige Expertengruppe für künstliche Intelligenz“ (HLEG). Bereits 2019 veröffentlichte diese ihre Leitlinien – als ethischen Rahmen „vertrauenswürdiger KI“ (EU-Kommission 2019). Der Regulierungsanspruch hatte seither also auch nach Aktenlage eine „ethische“ Dimension. Vielleicht noch wichtiger aber ist die Feststellung, dass dem Anspruch nach Regulierung die Reflexion von Regulierungslücken und kollidierenden Wert-, also Moralvorstellungen, zwischen dem europäischen Kultur- und Wirtschaftsraum und den dominierenden Techniktreibern aus dem angelsächsischen, aber auch asiatischen Raum vorausging. Die Reflexion von Moral und allen sich daraus ergebenden faktischen und handlungsleitenden Konsequenzen erfüllt im Kern tatsächlich eine Definition von angewandter Ethik. Trotz alledem bleibt im Ergebnis ein großes Unbehagen und der von Prof. Metzinger darauf gemünzte Begriff des „ethics washing“ lässt sich nur schwer entkräften (Prof. Metzinger war Mitglied der besagten HLEG): „[…] Ethics Washing, dass man oberflächliche Selbstverpflichtung oder Ethikkodizes veröffentlicht, die eigentlich nicht ernst gemeint sind, die aber demonstrieren sollen, dass man sensibel gegenüber ethischen Fragen bei dieser Technologie und auch bei ihrer kulturellen Einbettung ist“ (Deutschlandfunk 2021).

Konkret hat die HLEG die Debatte und den Gesetzgebungsprozess, trotz aller zutreffender Kritik, durchaus bereichert und bis heute richtungsweisende Kriterien unter dem eigens geschaffenen Begriff der „Vertrauenswürdigkeit“ von KI formuliert. Im Kern geht es dabei um den Vorrang menschlichen Handelns beziehungsweise menschlicher Aufsicht mit Bezug auf die EU-Grundrechtecharta, die Robustheit und Sicherheit der KI, den Schutz der Privatsphäre, Fragen des Datenqualitätsmanagements, der Transparenz, der Nachverfolgbarkeit und Erklärbarkeit sowie der Vielfalt, Nichtdiskriminierung und Fairness, bis hin zur Rechenschaftspflicht und vielem mehr. Dadurch wären potenziell weite Bereiche der Bedenken und Kritikpunkte abgedeckt, die in der damit befassten Community seit Jahren diskutiert werden (vgl. Bretschneider-Hagemes 2022).

Faktisch bleibt nach einem zähen Gesetzgebungsprozess, diversen Kompetenzstreitigkeiten und einem teils unsäglichen Gerangel im Trilog, bis hin zur noch andauernden Verabschiedung des Gesetzes, nur ein Teil erhalten. Tatsächlich orientieren sich Verbote und Risikoklassifizierungen weiterhin an einem wertebasierten Rahmen (glücklicherweise wurde beispielsweise die Emotionserkennung am Arbeitsplatz nach langen Forderungen der Gewerkschaften und Nichtregierungsorganisationen verboten). Allerdings wurde die KI-Definition des Ursprungsentwurfs aufgeweicht (mit Folgen für den Geltungsbereich) und wesentliche Vorgaben wurden zu ganzen Teilen in den Bereich freiwilliger Anwendung verschoben (vgl. Algorithm Watch 2021, s. „Weitere Infos“). Eine KI muss schon als „hoch riskant“ definiert sein, damit die Anforderungen der Verordnung, in denen sich vielfach die oben benannten Kriterien der HLEG wiederfinden, erfüllt werden müssen (vgl. vor allem Kapitel 2 des Kompromisspapiers der Kammern nach den Trilogverhandlungen).

Neue psychische Belastung durch KI?

Wenn im Folgenden einige für den Arbeitsschutz und vor allem psychische Belastungen relevante Entwicklungen der Digitalisierung mit Fokus auf die Auswirkungen von KI diskutiert werden, geschieht dies zunächst exemplarisch. Einen besonderen Stellenwert nimmt dabei der Aspekt „Selbstwirksamkeit“ ein, als einem wesentlichen salutogenen Faktor für die psychische Gesundheit. Dessen umfassende Bedeutung für die Gesunderhaltung der Beschäftigten steht noch immer im krassen Gegensatz zur vergleichsweisen geringen Beachtung im Bereich der Prävention und Regulierung. Im Hinblick auf die so genannte ethische Dimension der KI-Anwendung ergibt sich eine explizite Anschlussfähigkeit.

Bezogen auf Arbeitsplätze findet sich KI in Arbeitsmitteln, die mit Beschäftigten interagieren (Roboter, Maschinen etc.), aber auch in solcher Technik, die durch automatisierte Entscheidungsfindung Folgen für die Beschäftigten und deren Arbeitshandeln hat, ohne dass die betroffenen Personen darauf Einfluss nehmen könnten (HR-Tools, Arbeitsverteilung in algorithmisch gesteuerten Arbeitssystemen usw.), auch unter dem Oberbegriff AIWM (Artificial Intelligence for Worker Management) beschrieben (vgl. Christenko 2022).

Die erste Kategorie hat eine hohe Relevanz für den Bereich Mensch-Computer-

und Mensch-Roboter-/Maschinen-Interaktion (HCI/HRI/HMI) sowie Produktsicherheit, und in Fragen der mentalen Arbeitsbelastung geht es um die hochrelevanten, aber bekannten und relativ gut erforschten Herausforderungen rund um kognitive Anforderungen und ein geeignetes Schnittstellendesign (vgl. exemplarisch Rosen et al. 2022, 4.1.3 für EU OSHA). Die letztere Kategorie führt jedoch zu grundlegenderen und ethischen Fragen der Autonomie der Beschäftigten. Hier ergeben sich neue Fragestellungen zu psychischen Anforderungen und Stress, die im Folgenden als Kernaspekt thematisiert werden.

Grundlage gemeinsames Verständnis von Stress?

Schon die Rahmenrichtlinie für Sicherheit und Gesundheitsschutz am Arbeitsplatz formuliert die Verpflichtung zum Schutz der Beschäftigten durch die Vermeidung, Bewertung und Bekämpfung von Risiken, einschließlich aller potenziellen Risiken (EWG 1989, s. „Weitere Infos“). Die Spezifikationen bleiben jedoch sehr allgemein und nur einige Mitgliedsstaaten spezifizieren die Anforderungen hinsichtlich der Prävention psychischer Belastungen (PSR). Das Beispiel des Arbeitsschutzgesetzes in Deutschland weist die Vorgabe für eine menschengerechte Gestaltung der Arbeit auf (Bundesministerium der Justiz 2013, § 2, s. „Weitere Infos“).

Allerdings wurde der Aspekt PSR erst Ende 2013 durch einen Hinweis untermauert. Gefährdungen müssen seither explizit auch im Hinblick auf „psychische Belastungen am Arbeitsplatz“ identifiziert und Maßnahmen ergriffen werden (§ 5). Das Arbeitsprogramm Psyche der Gemeinsamen Deutschen Arbeitsschutzstrategie (GDA) gibt zudem Empfehlungen zur Berücksichtigung psychischer Belastungen in der Gefährdungsbeurteilung (GDA 2022).

Gewerkschaften fordern schon seit Längerem, dass diese allgemeine Vorgabe durch das staatliche Regelwerk weiter spezifiziert werden muss, um in der betrieblichen Praxis Wirkung zu entfalten (vgl. exemplarisch Fergen 2015). Das Fehlen expliziter gesetzlicher Anforderungen über einen langen Zeitraum öffnete den Raum für private Regelungen, wie sie im Bereich der Normung zu finden sind. Die ISO-Norm 9241-2, die sich ursprünglich auf Büroarbeit und deren Anforderungen an die spezifische Mensch-Computer-Interaktion konzentrierte, wird in der Praxis häufig zur Schließung der Regelungslücke herangezogen und genutzt, da sie sogenannte Humankriterien für die Gestaltung der Arbeitsaufgabe definiert. Dazu gehören Aspekte wie die Ganzheitlichkeit der Aufgabe, Handlungsspielräume und Fragen der Lernförderlichkeit (ISO 1992). Darüber hinaus wird seit vielen Jahren die Normenreihe DIN EN ISO 10075 eingesetzt, um diese Lücke zu schließen (ISO/TC159/SC1 1991). Ein Problem dieser Normendokumente besteht neben inhaltlichen Defiziten darin, dass diese Standards nicht von demokratisch legitimierten Gremien verfasst werden und die Akzeptanz zwischen den Beteiligten zu Recht stark schwankt.

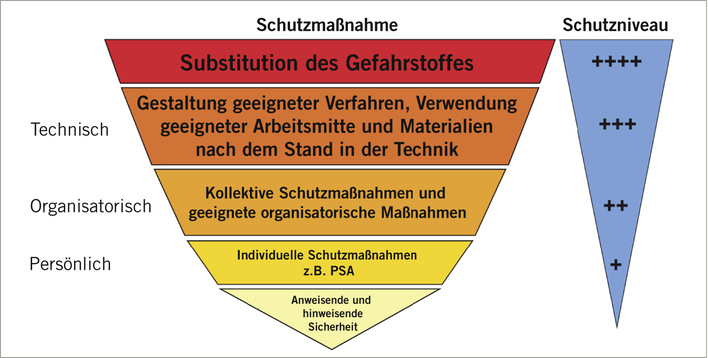

In Anlehnung an die ISO 10075 wird der Begriff „Stress“ meist durch eine Kombination aus sogenanntem psychischem Stress und Stressreaktionen definiert. Unter psychischem Stress versteht man hier „die Gesamtheit aller (…) Einflüsse, die von außen auf einen Menschen einwirken und ihn psychisch beeinträchtigen“. Unter der sogenannten Stressreaktion wird ein „Zustand innerhalb des Individuums verstanden, der (…) aus der negativen Interpretation einer Person der auf sie einwirkenden psychischen Belastung im Vergleich zu ihren verfügbaren Ressourcen entsteht.“ Aufgrund der Diskrepanz zwischen den Definitionen von psychischem Stress und Stressreaktion ergeben sich Probleme: Stress konzentriert sich zunächst auf die Umgebungsbedingungen. Gleichzeitig wird jedoch der Begriff neutralisiert, Stress wird in eine neutrale Gesamtheit von Einflüssen verklärt. Der Begriff der Stressreaktion erklärt dann individuell manifesten Stress zu einer „negativen Interpretation“. Dieser Logik folgend liegt die Verantwortung für psychische Probleme zu schnell beim Betroffenen beziehungsweise bei mangelnden individuellen Ressourcen. Weitere Teile der Normenreihe und einige Schriften des Arbeitsschutzes basieren auf diesen Grundlagen. Was hier außer Acht gelassen wird ist die Tatsache, dass es in Arbeitskontexten objektive Faktoren gibt, die Menschen psychisch krank machen und die unabhängig von individuellen Ressourcen als objektive Stressfaktoren benannt werden müssen (die Grundthese wird seit langem Zeit empirisch gestützt – vgl. zum Beispiel Siegrist 1996). Selbstverständlich mildern die individuellen Ressourcen weiterhin die mehr oder weniger einschneidenden gesundheitlichen Auswirkungen ab, der objektive Stressfaktor bleibt jedoch pathogen und muss als solcher angegangen werden, ohne sich dabei vornehmlich auf Aspekte wie Coping/Bewältigungsstrategien usw. zu stützen. Auf der Grundlage dieser Überlegungen kann nun PSR im Zusammenhang mit KI exemplarisch analysiert werden.

Das Konzept der Selbstwirksamkeit – ein Schlüssel zur Prävention an KI-basierten Arbeitsplätzen

Im Mittelpunkt dieses Ansatzes steht die Erfahrung der Selbstwirksamkeit als einem universellen psychologischen Bedürfnis des Menschen. Der Ansatz wurde im Kontext der Motivationstheorie als personal causation bezeichnet. DeCharms (1976) stellt fest, dass der Mensch das wesentliche Bedürfnis hat, der Urheber der Kausalität, der Ausgangspunkt, also der souveräne Akteur seines eigenen Verhaltens zu sein. Menschen streben nach kausaler Autonomie als Grundbedürfnis Hierbei handelt es sich nicht nur um individuelle Selbstwirksamkeitsüberzeugungen, wie sie von Bandura (1977) und von Metz u. Rothe (2016, S. 12) weiter spezifiziert und beispielhaft angewendet wurden. Wichtiger noch ist die Frage nach der Ursache und dem Ursprung dieser „Überzeugungen“, der in den Arbeitsbedingungen und der Rolle des Menschen im Arbeitssystem liegt (vgl. exemplarisch Pfeiffer et al. 2012, S. 268, Tintor 2015, S. 205). Die Erfahrung der Selbstwirksamkeit, die Erfahrung der eigenen Souveränität als selbstbestimmter Akteur seiner selbst, ermöglicht es Menschen, ihre Potenziale als Individuum zu entfalten (vgl. Heslin und Klehe 2006, S.706). Zu diesen Potenzialen gehört auch die Salutogenese am Arbeitsplatz: Menschen mit ausgeprägter Erfahrung ihrer Kompetenz und der Fähigkeit, mit dem Erleben ihre Umwelt zu beeinflussen, sind weniger anfällig für Depressionen und andere Krankheiten. Mit der Erfahrung der Selbstwirksamkeit ist auch die Bewältigung von Hochstresskonstellationen und überhaupt beruflicher Erfolg verbunden. Als Konsequenz der Erfahrung (!) der Selbstwirksamkeit stellt sich auch die Überzeugung der Selbstwirksamkeit ein. Diese mündet in einer positiven Erwartungshaltung, einer positiven Einstellung und Attribution von Anforderungen aus der Umwelt durch die Individuen. Ursache (!) bleiben jedoch die objektiven Arbeitsbedingungen, die das Erleben dieser Potenziale und deren Entfaltung erst ermöglichen müssen (vgl. exemplarisch Glaser et al. 2019; Luszczynska 2005, S. 1). Eng damit verbunden ist der geläufigere Aspekt von Ganzheitlichkeit und Autonomie: „Das heißt, der Mitarbeiter übt Tätigkeiten aus, bei denen er Gestaltungs- und Entscheidungsspielraum hat. Damit geht Verantwortung einher (…). Mit zunehmender Autonomie nimmt das Selbstwertgefühl und damit auch die Selbstwirksamkeit des Mitarbeiters zu“ (Netzwerk Mitbestimmte Personalarbeit 2009, S. 2). Im Ergebnis lässt sich festhalten, dass es sich um eine Frage der menschengerechten Gestaltung der Arbeit handelt. Der salutogene Zusammenhang wurde vielfach nachgewiesen (vgl. unter anderem Lampert et al. 2021; Singh et al. 2019) und doch hat das Konzept aus Sicht des Arbeitsschutzes bislang keine ausreichende Durchsetzungskraft erlangt. Ein Grund scheint in der Vereinfachung auf den Glauben an die Selbstwirksamkeit des Einzelnen zu liegen, anstatt konsequent an die Arbeitsbedingungen zu appellieren, die erst dazu führen. Dieses Problem ist nicht neu!

Nun, da künstliche Intelligenz vielfach als Instrument der Rationalisierung und Arbeitsverdichtung eingesetzt wird (obwohl die Technologie als solche auch andere Potenziale hätte), gefährdet sie die relativ ganzheitliche Natur und Autonomie der Arbeitsbedingungen. Heute und in Zukunft kommt dem Aspekt der Selbstwirksamkeit daher eine noch weitaus größere Bedeutung zu als früher.

Mit Verweis auf den Entwurf der europäischen KI-Verordnung wurde eingangs deren Geltungsbereich angesprochen. Dazu gehören wie gesehen auch Techniken, die den Arbeitsplatz durch automatisierte Entscheidungsfindung beeinflussen, ohne dass die Beschäftigten dies aktiv beeinflussen können (HR [Human Ressources]-Tools wie People Analytics, Arbeitsverteilung in algorithmisch gesteuerten Arbeitssystemen usw.). Diese Kategorie von KI-basierten Techniken ist diejenige, die Arbeitsplätze aus qualitativer Sicht im Hinblick auf die Autonomie der Beschäftigten und deren Aufgabenerfüllung am empfindlichsten beeinflusst. Am Beispiel automatisierte Arbeitsverteilung (Distribution von Arbeit) wird es deutlich: Solche Systeme basieren auf Daten, die aus detailliert analysierten Arbeitsabläufen, beispielsweise im Bereich der Intralogistik und Fertigung, gewonnen werden. Dazu gehören detaillierte Angaben zu den Vorkenntnissen der Beschäftigten und zur Ausübung der Tätigkeit einschließlich Routen, Handbewegungen, Informationsbeschaffung und -übertragung etc. Diese Informationen werden in einem Ausmaß objektiviert, wie es selbst dem traditionellen Taylorismus (also der hoch arbeitsteiligen Trennung von Hand und Kopfarbeit aufgrund so genannter “wissenschaftlicher Betriebsführung”) fremd war. Erst die umfassende und oft sensorgestützte Erfassung von Informationen, gepaart mit komplexen algorithmischen Steuerungen machten dies möglich. Echtzeitinformationen werden vom System berücksichtigt und entsprechend in den Prozess eingebunden. Der Output der Systeme entwickelt und verändert sich im Laufe seines Lebenszyklus, oft intransparent für die Beschäftigten, die damit interagieren. Die Beschäftigten erhalten ihre Aufgaben in Echtzeit, gelegentlich über ein digitales Wearable, das mit der Black Box KI verbunden ist. Die Tätigkeit wird dann unter algorithmisch optimierter Routenführung und detailliertem Prozessmanagement verengt. Den ausführenden Beschäftigten, deren Qualifikationen einst so wichtig waren, bleibt eine Restarbeit, weit davon entfernt, ganzheitlich zu sein. Diese Art der Arbeitsplatzgestaltung konnte in den letzten Jahren auch deshalb gedeihen, da sie oft kostengünstiger und flexibler ist als eine Vollautomatisierung.

Es ist sehr bedauerlich, aber wenn unter der Prämisse der Rationalisierung nicht nur auf die wünschenswerten Potenziale künstlicher Intelligenz im Bereich so genannter Wissensarbeit geschaut werden darf, sondern auch negative Auswirkungen, gerade im Bereich der weniger wissensintensiven Tätigkeiten kritisiert werden müssen, dann lässt sich nicht leugnen, dass ein Zustand eintreten kann (zumindest als Tendenz innerhalb der Aufgabengestaltung), den der Anthropologe David Graber in seiner maßgeblichen Publikation etwas rustikal als „Bullshit Jobs“ bezeichnete (vgl. Graeber 2018). Wer sich auch nur ansatzweise mit der Gestaltung von Arbeitssystemen beschäftigt hat, kann die negativen Konsequenzen dieser Variante des neuen Taylorismus im Hinblick auf die menschengerechte Gestaltung von Arbeit erahnen. In solchen Szenarien werden Beschäftigte von ihrer gattungscharakterlichen Potenz abgeschnitten, ein immenses Arbeitsvermögen (in Anlehnung an Sabine Pfeiffer) zu entwickeln und nach Innovation zu streben (Pfeiffer et al. 2012. Darüber hinaus wird die salutogene Dimension der Erfahrung von Selbstwirksamkeit im Arbeitsprozess beeinträchtigt. „Autonom“ bleibt hier nur der Algorithmus. Ein typischer Arbeitsplatz der befürchteten Blackbox Society (Pasquale 2015) nimmt diese Formen an, wenn keine entsprechenden Regulierungen und Maßnahmen ergriffen werden, um dem entgegenzuwirken. Dabei ist zu bedenken, dass nicht nur „sortenreine“ Ausprägungen zu beobachten sind, sondern vor allem, dass Teilaspekte von Arbeitstätigkeiten auf diese Weise an Algorithmen delegiert werden. Solange diese Ausprägungen noch nicht den wesentlichen Charakter des Arbeitsplatzes ausmachen, ist das nicht unbedingt problematisch. Wenn dadurch jedoch die Transparenz und noch mehr die Autonomie des Arbeitshandelns unterdrückt wird, dann entsteht ein objektiver Stressfaktor, der einen Kernaspekt der Prävention psychischer Belastungen betrifft und zukünftig auch in betrieblichen Gefährdungsbeurteilungen berücksichtigt werden muss. Die kommende KI-Verordnung wird in Anbetracht oftmals nur freiwilliger Vorgaben und ihrem Charakter als Binnenmarktverordnung nur teilweise helfen.

Fazit

Der Gesetzesentwurf zur KI-Verordnung befasst sich hauptsächlich mit der Inverkehrbringung von Produkten. Da es sich um eine Binnenmarktverordnung und nicht um eine Arbeitsschutzverordnung handelt, müssen die diesbezüglichen Vorgaben schon aus rechtssystematischen Gründen vage bleiben. Die Binnenmarktverordnung folgt dem Prinzip des New Legislative Framework (NLF); für die Konkretisierung der vorgeschlagenen Rechtsvorschriften ist das Instrument der harmonisierten Normung einschlägig. Auf die Grenzen und Akzeptanzprobleme der Normung wurde hingewiesen. Gerade wenn Kriterien der besprochenen Ethikdimension nun in der Normung ausformuliert werden, dann trägt das wilde Blüten, wie etwa an den Bestrebungen zu einem Ethiklabel zu erkennen ist, das an den allseits bekannten Nutriscore auf Lebensmitteln erinnert. Die konkrete betriebliche Problematik der psychischen Belastungen erfährt nur wenige hilfreichere Impulse aus diesen Regulierungsebenen. Es bleibt daher zu fordern, dass unter dem Gesichtspunkt der Erhaltung der Gesundheit der Beschäftigten die europäische Gesetzgebung zum Arbeitsschutz gemäß Artikel 153 AEUV (Vertrag über die Arbeitsweise der Europäischen Union; EU 2008, s. „Weitere Infos“) der Ergänzungen bedarf, um den Herausforderungen durch den technologischen Wandel präventiv begegnen zu können. Nur auf Binnenmarktverordnungen und Normen zu setzen, wird absehbar nicht genügen.

Die Gesetzgebung, sei es national oder europäisch als Mindestanforderung, muss den objektiven psychischen Belastungen durch KI am Arbeitsplatz gerecht werden und damit auch einen ethischen Anspruch einlösen. Hierzu muss der Aspekt der ganzheitlichen Arbeit konkretisiert und folglich als praktisch durchsetzbares Recht geltend gemacht werden können. Die Besonderheiten der KI-gestützten Arbeitssysteme, wie etwa die Intransparenz, müssen arbeitsschutz- und nicht nur produktspezifisch aufgegriffen und im Sinne der Rechtsklarheit spezifiziert werden. Auch und gerade sogenannte Einfach- oder Basisarbeit kann in diesem Sinne durch eine relative Autonomie der Beschäftigten innerhalb der Arbeitssysteme humanisiert werden.

Grundsätzlich sollte der Stressbegriff rechtsverbindlich definiert und objektive Faktoren berücksichtigt werden. Diese sind aufgrund der Evidenz als objektiv gefährdend zu bezeichnen und nicht, wie bisher allzu häufig, auf die Interpretation und die (vermeintlich unzureichenden) Ressourcen des Einzelnen zurückzuführen. Die salutogenen Potenziale am Arbeitsplatz müssen nach Möglichkeit durch eine starke Kompetenz- und Autonomieerfahrung der Menschen erhalten bleiben und weiter generiert werden. Es konnte gezeigt werden, dass sich als Konsequenz der Erfahrung der Selbstwirksamkeit die Überzeugung und Erwartung einstellt, die eine positiven Zuschreibung von Anforderungen durch die Individuen führt. Die objektiven Arbeitsbedingungen sind ihre Ursache im Sinne menschengerechter und ganzheitlicher Rahmenbedingungen, die Entscheidungsspielraum und individuelle Autonomie bewahren. Darin trifft sich der Anspruch einer ethischen KI-Anwendung mit der Gesunderhaltung der Beschäftigten.

Interessenkonflikt: Der Autor gibt an, dass kein Interessenkonflikt vorliegt.

Literatur

Algorithm Watch: EU policy makers: Protect people s rights , don’t narrow down the scope of the AI Act! 2021. https://algorithmwatch.org/en/statement-scope-of-eu-ai-act/

Bandura A: Self-efficacy: toward a unifying theory of behavioral change. Psychological Review 1997; 84: 191–215.

Bretschneider-Hagemes M: Künstliche Intelligenz (KI) und das Arbeiten in der Blackbox – Eine Zuspitzung. In: Pieper R, Lang K-H (Hrsg.): 41. ASER-Forschungsbericht. Wuppertal: ASER Eigenverlag, 2022.

Bundesministerium der Justiz. Gesetz über die Durchführung von Maßnahmen des Arbeitsschutzes zur Verbesserung der Sicherheit und des Gesundheitsschutzes der Beschäftigten bei der Arbeit (Arbeitsschutzgesetz – ArbSchG). https://www.gesetze-im-internet.de/arbschg/

Christenko A, Jankauskaitė V, Paliokaitė A, Van Den Broek L, Reinhold K, Järvis M: Artificial intelligence for worker management: an overview. Bilbao: European Agency for Safety and Health at Work – EU-OSHA, 2022.

DeCharms R: Enhancing Motivation. Hoboken: Wiley, 1976.

Deutschlandfunk: Thomas Metzinger im Gespräch mit Thekla Jahn am 11.06.2021.

Europäische Kommission: Ethik-Leitlinien für eine vertrauenswürdige Ki – Hochrangige Expertengruppe für künstliche Intelligenz, Brussels, 2019. https://digital-strategy.ec.europa.eu/en/library/ethics-guidelines-trus…

Europäische Kommission: Vorschlag für eine Verordnung des Europäischen Parlaments und des Rates über Maschinenprodukte. Brüssel, 2021.

Europäische Kommission: Vorschlag für eine Verordnung des Europäischen Parlaments und des Rates über Maschinenprodukte. Brüssel, 2021. https://eur-lex.europa.eu/resource.html?uri=cellar:1f0f10ee-a364-11eb-9…

European Commission: EU strategic framework on health and safety at work 2021–2027. Occupational safety and health in a changing world of work. Brussels, 2021.

EWG COUNCIL DIRECTIVE of 12 June 1989 on the introduction of measures to encourage improvements in the safety and health of workers at work, 1989. https://eur-lex.europa.eu/eli/dir/1989/391/oj

Fergen A: Neue Arbeitswelt – alter Arbeitsschutz. Die Anti-Stress-Initiative der IG Metall. Ethik und Gesellschaft 2015; 2 (Open Access: https://dx.doi.org/10.18156/eug-2-2015-art-7 (abgerufen am 22.05.2024).

GDA-Arbeitsprogramm Psyche: Berücksichtigung psychischer Belastung in der Gefährdungsbeurteilung – Empfehlungen zur Umsetzung in der betrieblichen Praxis“. Berlin: BMAS, 2022.

Glaser J, Hornung S, Höge T, Seubert C, Schoofs L: Zusammenhänge zwischen Arbeitsanforderungen und -ressourcen für Lernen, Selbstregulation und Flexibilität. Zeitschrift für Arbeitswissenschaft 2019; 73: 274–284.

Graeber D: Bullshit jobs: a theory. New York: Simon & Schuster“, 2018.

Heslin PA, Klehe UC: Self-efficacy. Organisational Psychology 2018; 2: 706.

ISO: ISO 9241-2:1992-06 „Ergonomic requirements for office work with visual display terminals (VDTs); part 2: guidance on task requirements“. 1992.

ISO/TC159/SC1: ISO 10075 „Ergonomic principles related to mental workload“. 1991.

Lampert B, Hornung S, Glaser J: Detached concern and well-being: mediating roles of occupational self-efficacy and meaning in work as psychological resources. Prävention und Gesundheitsförderung 2021; 16 (3).

Luszczynska A: General self-efficacy in various domains of human functioning. Int J Psychol 2005; 40: 1.

Metz A-M, Rothe H-J: Psychische Belastung, psychische Beanspruchung und Beanspruchungsfolgen. In: Metz A-M, Rothe H-J (Hrsg.): Screening psychischer Arbeitsbelastung. Wiesbaden: Springer Fachmedien, 2016, S. 12.

Netzwerk Mitbestimmte Personalarbeit: Hinweise zur Arbeitsgestaltung. 2009, S. 2.

Pasquale FA: The Black Box Society: The secret algorithms that control money and information. Cambridge MA: Harvard University Press, 2015.

Pfeiffer S, Schütt P, Wühr: Smarte Innovation – Ergebnisse und neue Ansätze im Maschinen- und Anlagenbau“. Wiesbaden: Springer VS, 2012.

Rosen PH, Heinold E, Fries-Tersch E, Wischniewski S: Advanced robotics and automation: implications for occupational safety and health Report. Bilbao: European Agency for Safety and Health at Work – EU-OSHA, 2022, 4.1.3.

Siegrist J: Adverse health effects of high-effort/low-reward conditions. J Occup Health Psychol 1996; 1: 27–41.

Singh SK, Pradhan RK, Panigrahy NP, Jena LK: Self-efficacy and workplace well-being: moderating role of sustainability practices. Benchmarking, 2019; 26 (Open Access: doi:10.1108/BIJ-07-2018-0219).

Tintor M: Betriebliches Gesundheitsmanagement in Restrukturierungsprozessen. Wiesbaden: Springer-Gabler, 2015, S. 205.

Weitere Infos

Algorithm Watch: EU policy makers: Protect people s rights , don’t narrow down the scope of the AI Act! 2021

https://algorithmwatch.org/en/statement-scope-of-eu-ai-act/

Bundesministerium der Justiz. Gesetz über die Durchführung von Maßnahmen des Arbeitsschutzes zur Verbesserung der Sicherheit und des Gesundheitsschutzes der Beschäftigten bei der Arbeit (Arbeitsschutzgesetz – ArbSchG)

https://www.gesetze-im-internet.de/arbschg/

EWG COUNCIL DIRECTIVE of 12 June 1989 on the introduction of measures to encourage improvements in the safety and health of workers at work, 1989

https://eur-lex.europa.eu/eli/dir/1989/391/oj

Europäische Kommission: Vorschlag für eine Verordnung des Europäischen Parlaments und des Rates über Maschinenprodukte. Brüssel, 2021

https://eur-lex.europa.eu/resource.html?uri=cellar:1f0f10ee-a364-11eb-9…

Europäische Kommission: Ethik-Leitlinien für eine vertrauenswürdige Ki – Hochrangige Expertengruppe für künstliche Intelligenz, Brussels, 2019

https://digital-strategy.ec.europa.eu/en/library/ethics-guidelines-trus…

European Union: Consolidated version of the Treaty on the Functioning of the European Union - Part Three: Union Policies and Internal Actions – Article 153, 2008.

https://www.legislation.gov.uk/eut/teec/contents